Als Apple vor einigen Wochen sein neues iPad Air vorstellte, war erst einmal alles wie immer. Das moderne Design wurde abgefeiert, der große Bildschirm, die bunten Farben. Doch dann folgte etwas, das selbst Branchenkenner*innen überraschte: Im Inneren des Mittelklasse-iPads steckte kein Prozessor aus dem Vorjahr, sondern der brandneue A14-Chip. Der wurde eigentlich erst zusammen mit den neuen iPhones erwartet, die in den nächsten Wochen der Weltöffentlichkeit vorgestellt werden.

Nun ist ein neuer Prozessor im Allgemeinen nichts, was die Leute zuhause vor den Bildschirmen ausflippen lässt. Oft geht es dabei um eine Aneinanderreihung von Rechenkernen und Fachbegriffen. 30 Prozent Leistungssteigerung hier, ein paar Milliarden zusätzliche Transistoren da. Das ist beeindruckend, doch viele haken das als technisches Kleinklein für Nerds ab. Schließlich sind unsere Smartphones und Tablets schon seit Jahren so schnell, dass man sich unweigerlich fragt: Wozu braucht man noch mehr Rechenpower?

Das iPad wird zum Agentenwerkzeug

Eine Antwort darauf gibt Andrius Gailiūnas, der für die Bildbearbeitungs-App Pixelmator Photo arbeitet. Wobei, ist Bildbearbeitung überhaupt noch das richtige Wort für eine solch mächtige Software? Denn mit dem Tool ist es neuerdings möglich, in ein Foto hineinzuzoomen, bis es immer unschärfer und damit pixeliger wird - und anschließend rechnet eine Künstliche Intelligenz das Bild wieder "glatt".

Die Software fügt quasi Informationen in das Bild ein, die zuvor nicht existiert haben, ohne dass es dem menschlichen Auge auffällt. "Jeder kennt diese Filme, in denen jemand auf einen Bildschirm zeigt und sagt: Hier stark vergrößern. Ich habe das auf das iPad gebracht", sagt Gailiūnas.

In Krimi-Serien wie "CSI" und den Bond-Filmen taten wir so etwas vor wenigen Jahren noch als unrealistischen Blödsinn ab. Auf Youtube kursiert ein solcher Ausschnitt unter dem Titel "Warum ich kein CSI schaue". Doch nun ist genau das in Grundzügen möglich - und zwar nicht auf einem Supercomputer des FBI, sondern in Geräten für wenige hundert Euro. Möglich machen das Prozessoren wie der neue A14-Chip von Apple.

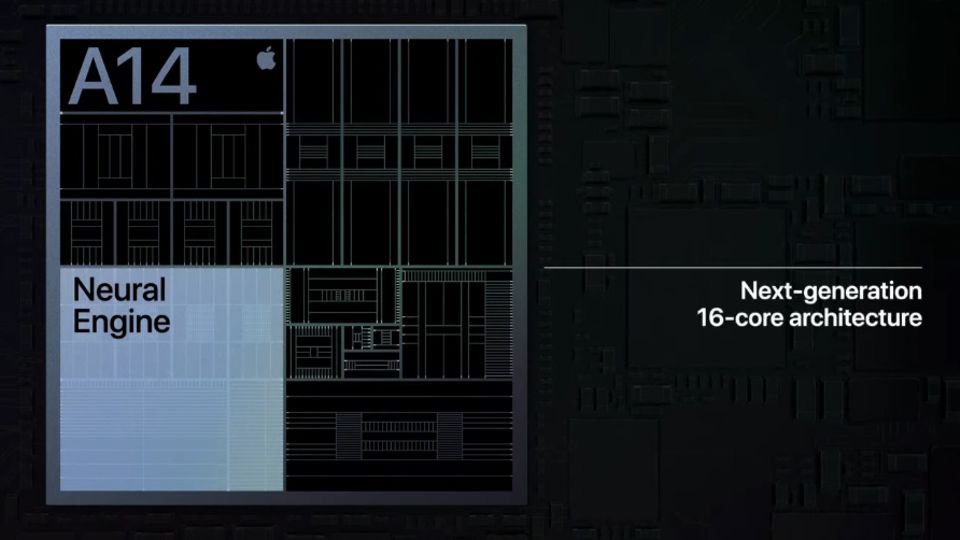

Neural Engine: Turbo für iPhone und iPad

Viele Jahre bestanden Chipsätze für Smartphones aus zwei wesentlichen Komponenten - einer Recheneinheit (CPU) und einer Grafikeinheit (GPU). Seit wenigen Jahren gibt es noch ein drittes Element, eine neuronale Recheneinheit (NPU), die bei Apple "Neural Engine" heißt, aber so ähnlich auch in Smartphones anderer Hersteller steckt. Während die CPU eine Aufgabe, welche aus mehreren Teilen besteht, nacheinander abarbeitet, ist die NPU in der Lage, einzelne Teile der Aufgabe gleichzeitig zu lösen.

Diese Stärke kommt etwa bei Sprachassistenten zur Geltung: Fragt man "Wie wird das Wetter am Montag in München?", sucht das iPhone nicht erst nach Wetterinformationen, dann nach dem Tag und anschließend den exakten Wetterdaten für München, sondern es ruft alle Informationen gleichzeitig ab. Das spart Zeit. Hinzu kommt: Eine NPU ist lernfähig und optimiert sich permanent selbst.

"Es verschlägt mir den Atem, wenn ich sehe, was Menschen damit anstellen"

Für Tim Millet, Apples Vice President für Platform Architecture und damit verantwortlich für die konzerneigene Chip-Entwicklung, ist die Neural Engine und die Integration von Machine Learning der Auftakt einer weitreichenden Rechen-Revolution. "Uns begeistert das Aufkommen des Maschinellen Lernens und wie es eine völlig neue Klasse ermöglicht" sagt Millet im Exklusiv-Gespräch mit dem stern. "Es verschlägt mir den Atem, wenn ich sehe, was Menschen mit dem A14-Bionic-Chip anstellen können."

Apple habe neuronale Netzwerke nicht erfunden, "die Grundlagen dafür liegen bereits viele Jahrzehnte zurück", so Millet. "Aber damals gab es zwei Probleme: Es fehlten die Daten und es fehlte die Rechenpower, um jene komplexen Modelle zu entwickeln, welche diese Datenmengen auch verarbeiten konnten." 2012 gab es schließlich einen Durchbruch, welcher die Trainingszeiten von Modellen enorm beschleunigte. Erst dadurch wurden Technologien wie Gesichtsentsperrungen in einem Smartphone überhaupt denkbar.

Die Grenzen der Physik

Die Fortschritte sind immens: Die Neural Engine im A11-Chip, der 2017 im iPhone X steckte - das erste Modell mit Gesichtsentsperrung - konnte 600 Milliarden Rechenoperationen pro Sekunde verarbeiten. Beim A14 Bionic sind es bereits 11 Billionen Berechnungen pro Sekunde.

Die Grundlage dafür sind auch neue Fertigungstechniken. Der A9-Chip, der im iPhone 6s im September 2015 seine Premiere feierte, wurde noch im 16-Nanometer-Verfahren gefertigt. Fünf Jahre später ist Apple beim A14-Chip nun als erster Hersteller der Welt bei fünf Nanometern angekommen. Sollte dieses Tempo beibehalten werden, dürfte man bald an die Grenzen des physikalisch Machbaren geraten.

Für 2022 werden 3-Nanometer-Chips erwartet, danach wird die Luft dünn. Ob sich in zehn Jahren kleine Quantencomputer in unseren Hosentaschen und an unseren Handgelenken befinden werden, wird sich zeigen. Millet stellt jedoch eine "wirklich starke Roadmap" in Aussicht: "Wir arbeiten eng mit unseren Technologiepartnern auf der ganzen Welt zusammen, um zu gewährleisten, dass wir auf dem richtigen Weg sind. Wir werden intensiv weiterentwickeln und sind noch längst nicht am Ende angekommen."

Eine Frage der Software

Dennoch solle man den Wert der 5-Nanometer-Fertigung nicht überschätzen, erklärt Apples Platform-Chef Tim Millet. "Sie verleiht uns wichtige Fähigkeiten. Und Apple ist in einer großartigen Position, um davon zu profitieren." Doch bloße Rechenpower allein macht noch keine Revolution. Denn was nützt die größte Brechstange, wenn man nicht weiß, wo und wie sie anzusetzen ist. Ebenso wichtig ist die Implementierung der Software und der passenden Schnittstellen für Entwickler.

Und hier ist kein Konzern so gut aufgestellt wie Apple, ist Millet überzeugt. "Wir arbeiten während der gesamten Entwicklung sehr eng mit unserem Software-Team zusammen, um sicherzustellen, dass wir nicht nur ein Stück Technik bauen, das für wenige nützlich ist. Wir wollten sicherstellen, dass Abertausende von iOS-Entwicklern etwas damit anfangen können."

Seit 2018 können App-Entwickler mit einer speziellen Schnittstelle namens Core ML auf die Neural Engine im iPhone- und iPad-Chip zugreifen und so die Vorzüge des Maschinellen Lernens für ihre Anwendungen nutzen. Sie müssen gewissermaßen die Anleitung schreiben, Apple stellt quasi nur das Gehirn zur Verfügung. "Core ML ist eine fantastische Möglichkeit für Leute, die verstehen und herausfinden wollen, welche Möglichkeiten sie haben", so Millet. "Wir haben viel Zeit darin investiert, um sicherzustellen, dass wir nicht nur Transistoren in den Chip packen, die dann nicht genutzt werden. Wir wollen, dass die Masse darauf zugreift."

Neuronale Netzwerke treffen auf DJ-Kultur

Gemeint sind damit Menschen wie Karim Morsy. Der mittlerweile 37-jährige Münchner gründete 2006 das Start-up Algoriddim, mit seiner DJ-App Djay landete er einen internationalen Beststeller auf dem iPad. Anfangs konnte man in der Anwendung lediglich virtuelle Schallplatten drehen, mittlerweile ist weitaus mehr möglich: "Wir haben es geschafft, Musik auf dem iPad in Echtzeit zu trennen. Bislang mussten DJs lange kompliziert mit vielen Equalizern arbeiten, ohne Spuren wirklich trennen zu können, nun genügt ein Knopfdruck. Dadurch kann man völlig neuartige Musik kreieren, indem man etwa die Stimmen aus Musiktiteln wegzaubern und diese in einem anderen Track dazuschalten kann."

Morsys iPad-App ist in der Lage, automatisch zwei verschiedene Songs auf das gleiche Tempo, die gleiche Tonart und den gleichen Rhythmus zu bringen. Besitzt das Gerät einen Bionic-Chip mit Neural Engine, kann es dank der Anbindung an das neuronale Netzwerk zudem einzelne Spuren beliebig herausfiltern. "Dadurch kann man etwa in Echtzeit die Gitarre von Jimi Hendrix statt des Klaviers von Rihanna in einen Song einbauen. Das ist der Wahnsinn. An solche Dinge habe ich vor ein paar Jahren nicht einmal zu denken gewagt."

Der Einsatz von Künstlicher Intelligenz wird sich auf alle Bereiche erstrecken, davon ist Morsy überzeugt. "Ich halte das für hochgradig relevant. Das ist definitiv das nächste Level." Vor allem im Bereich der Fotografie ist die Schlagzahl hoch: Google setzte vor einigen Jahren als einer der ersten Konzerne auf computergestützte Fotografie, mittlerweile hat die Technik auch auf dem iPhone Einzug gehalten.

Für die Profi-Software Adobe Photoshop wurde jüngst eine neue Funktion angekündigt, mit der mit einem Klick der Himmel auf einem Foto ausgetauscht und automatisch die gesamte Lichtstimmung des Fotos angepasst werden kann. Heißt: Dank Künstlicher Intelligenz muss man sich in Zukunft für Sonnenuntergangsfotos nicht einmal mehr morgens den Wecker stellen.

Die Sache mit der Gesichtsmaske

Wie wichtig die Implementierung von zuverlässigen Modellen bei neuronalen Recheneinheiten ist, zeigt eine Technologie, die innerhalb weniger Jahre für viele von uns selbstverständlich geworden und mit dem Ausbruch der Corona-Pandemie wieder im Bewusstsein angekommen ist: die Gesichtserkennung. Denn seit wir alle im öffentlichen Raum einen Mund-Nasen-Schutz tragen, müssen wir plötzlich wieder Zahlencodes eintippen, statt das Telefon einfach entspannt aus der Tasche zu ziehen. Woran liegt das eigentlich?

"Es ist schwer, etwas zu erkennen, das man nicht sehen kann", erklärt Tim Millet. "Die Modelle zur Gesichtserkennung sind wirklich gut, aber es ist ein kniffliges Problem. Die Nutzer wünschen sich Bequemlichkeit, aber zugleich wollen sie sicher sein. Und bei Apple dreht sich alles darum, sicherzustellen, dass die Daten sicher bleiben."

Es seien Techniken vorstellbar, bei denen man den vom Mund-Nasen-Schutz verdeckten Teil des Gesichts ausspare, erklärt Millet. "Aber dann verliert man auch einige der Merkmale, die Ihr Gesicht einzigartig machen, wodurch es wiederum leichter vorstellbar ist, dass jemand das Telefon entsperren könnte."

Für die Android-Konkurrenz wird es hart

Wie schnell der A14-Chip genau ist, wissen derzeit nur Apple-Ingenieure. Das Gerät kommt erst im Laufe des Oktobers in den Handel. Doch am Wochenende ist ein vermeintlicher Leak des Benchmark-Programms Antutu im Netz aufgetaucht. Sollten die Daten echt sein, beträgt der Performance-Zuwachs zum Vorgängermodell 20 bis 30 Prozent. Damit würde Apple in Sachen Performance die Android-Konkurrenz deklassieren und sogar Chips der Konkurrenz schlagen, die erst 2021 auf den Markt kommen.

Doch auch Nutzer*innen, die weder aufwendig Fotos bearbeiten noch die Stimmen in ihren Lieblings-Songs vertauschen wollen, profitieren von einer solchen Leistung. Denn was jetzt überzogen wirken mag, dürfte in drei bis fünf Jahren der Standard sein - und so lange nutzen die meisten ihre Tablets.

Dass Apple seinem Mittelklasse-iPad den Premium-Chip spendiert, kann daher auch als Versprechen gewertet werden, dass dieses Gerät noch drei, vier oder gar fünf Jahre lang Updates erhalten wird. Und damit auch neue Funktionen, welche die Geräte der Kalifornier untereinander enger verschränken. Apple-Manager sprechen in diesem Zusammenhang gerne von "Magie". Doch selbstverständlich ist nichts Übernatürliches daran, wenn sich Kopfhörer besonders schnell mit dem Telefon verbinden oder ein Tablet zum weiteren Bildschirm des Computers wird. Es ist lediglich das Ergebnis vieler Arbeitsstunden von Ingenieuren.

Lesen Sie auch:

- Gesundheits-Offensive: Apples spannendstes Produkt ist nicht mehr das iPhone

- Interview mit Tim Cook: "Wir versuchen immer, unsere Preise so niedrig wie möglich zu halten"